Lenguaje de la PC

Sistema

Binario: Historia

El antiguo matemático Indio Pingala

presentó la primera descripción que se conoce de un sistema de numeración

binario en el siglo tercero antes de Cristo, lo cual coincidió con su descubrimiento del concepto del número cero.

El antiguo matemático Indio Pingala

presentó la primera descripción que se conoce de un sistema de numeración

binario en el siglo tercero antes de Cristo, lo cual coincidió con su descubrimiento del concepto del número cero.

El sistema binario moderno fue

documentado en su totalidad por Leibniz en el siglo XVII en su artículo "Explication de

l'Arithmétique Binaire". Leibniz usó el 0 y el 1, al igual que el sistema de numeración binario actual.

En 1854, el matemático británico

George Boole, publ icó un artículo que marcó un antes y un después, detallando un sistema de lógica

que terminaría denominándose Álgebra de

Boole. Dicho sistema jugaría un

papel fundamental en el desarrollo del sistema binario actual, particularmente en el desarrollo de

circuitos electrónicos.

En 1937, Claude Shannon realizó su

tesis doctoral en el MIT, en la cual implementaba el

Álgebra de Boole y aritmética

binaria utilizando re lés y conmutadores por primera vez en la historia. Titulada Un Análisis Simbólico de

Circuitos Conmutadores y Relés, la tesis de

Shannon básicamente fundó el diseño

práctico de circuitos d igitales.

En noviembre de 1937, George

Stibitz, trabajando por aquel entonces en los Laboratorios

Bell, construyó un ordenador basado

en relés - al cual apodó "Modelo K" (porque lo construyó en una cocina, en inglés

"kitchen")- que utilizaba la suma binaria para realizar los cálculos. Los Laboratorios Bell autorizaron

un completo programa de investigación a finales

de 1938, con Stibitz al mando. El 8 de enero de 1940 terminaron el

diseño de una

Calculadora de Números Complejos,

la cual era capaz de realizar cálculos con números complejos. En una demostración en la

conferencia de la Sociedad Americana de

Matemáticas, el 11 de septiembre de

1940, Stibitz logró enviar comandos de manera remota a la Calculadora de Números Complejos a

través de la línea telefónica mediante un teletipo.

Fue la primera máq uina computadora

utilizada de manera remota a través de la línea de teléfono. Algunos participantes de la

conferencia que presenciaron la demostración fueron

John Von Neumann, John Mauchly y

Norbert Wiener, el cual escribió acerca de dicho suceso en sus diferentes tipos de memorias en

la cual alcanzo diferentes logros.

Archivo

Binario

Un Archivo binario es un archivo

informático que contiene información de cualquier tipo, codificada en forma binaria para el propósito

de almacenamiento y procesamiento en ordenadores.

Por ejemplo los archivos informáticos que almacenan texto formateado o fotografías.

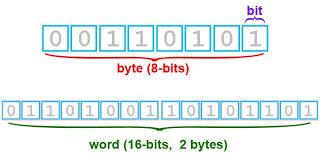

Bit, lo más pequeño del lenguaje

Bit es el acrónimo de Binary digit.

(dígito binario). Un bit es un dígito del sistema de numeración binario. La Real Academia Española

(RAE) ha aceptado la palabra bit con el plural

bits.

Mientras que en nuestro sistema de

numeración decimal se usan diez dígitos, en el binario se usan sólo dos dígitos, el 0 y el 1. Un bit

o dígito binario puede representar uno de esos

dos valores, 0 ó 1.

Origen del termino Bit

Claude E. Shannon primero usó la

palabra bit en un trabajo académico de 1948. Él atribuyó su origen a John W. Tukey, que había escrito

una nota en los laboratorios Bell el 9 de enero

de 1947 en la cual contrajo las palabras "binary digit"

(dígito binario) a simplemente "bit",

formando una palabra combinada.

Octeto

o Byte

Voz inglesa, se pronuncia báit, que

si bien la Real Academia Española ha aceptado como equivalente a octeto, es decir a ocho bits,

para fines correctos, un byte debe ser considerado

como una secuencia de bits contiguos, cuyo tamaño depende del código de información o código de caracteres en que sea

definido. Se usa comúnmente como unidad básica

de almacenamiento de información en combinación con los prefijos de cantidad.

Los prefijos kilo, mega, giga, etc.

se consideran múltiplos de 1024 en lugar de múltiplos de

1000. Esto es así porque 1024 es la

potencia de 2 (210) más cercana a 1000. Se utiliza una potencia de dos porque la computadora

trabaja en un sistema binario.

Sin embargo, para el SI, los

prefijos mantienen su significado usual de potencias de mil.

Así:

Codificación

del sistema Binario:

American Standard Code for

Information Interchange El código ASCII (acrónimo inglés de American Standard

Code for Information Interchange

— Código Estadounidense Estándar

para el Intercambio de Información), pronunciado generalmente [áski], es un

código de caracteres basado en el alfabeto latino tal como se usa en inglés moderno y en otras lenguas

occidentales. Fue creado en 1963 por el Comité

Estadounidense de Estándares (ASA,

conocido desde 1 969 como el Instituto

Esta dounidense de Estándares

Nacionales, o ANSI) como una refundición o evolución de los conjuntos de códigos utilizados entonces

en telegrafía. Más tarde, en 1967, se incluyeron las minúsculas, y se

redefinieron algunos códigos de control para formar el código conocido como US-ASCII.

Tabla

de Caracteres ASCII

Como hemos visto anteriormente la

tabla sirve para funciones internas de codificación, pero también el usuario puede utilizar esta tabla

para poder introducir un código ASCII (Letra,

Símbolo o Número) en un procesador

de texto o DOS, por ejemplo la letra Ñ, suele tener problemas si se configura

mal el teclado, utilizando el código ASCII, presionando la tecla ALT +

el código del carácter nos da

automáticamente el código en pantalla.

No hay comentarios:

Publicar un comentario